Negli anni, Internet è stato celebrato per le sue enormi potenzialità, quali la condivisione di dati e informazioni, la disseminazione di conoscenza, la promozione del dibattito pubblico, così contribuendo alla retorica entusiasta sulla cosiddetta intelligenza collettiva (Lévy & Bononno, 1997), una nuova forma di intelligenza che emerge dalla collaborazione e dagli sforzi collettivi dei singoli individui. La rete si caratterizza come un ambiente fortemente iperconnesso, in cui le comunicazioni sono rapide, facili, prive di ogni barriera spaziale e temporale. A questo proposito, focalizziamoci per un momento sulla teoria small-world testata da Milgram negli anni ’60 (Milgram, 1967). Lo psicologo statunitense voleva capire quanti intermediari sono necessari prima che due persone qualsiasi nel mondo siano connesse. Nell’esperimento, Milgram selezionò casualmente alcuni statunitensi del Midwest e chiese loro di inviare un pacchetto ad un destinatario (sconosciuto) nel Massachusetts, di cui era noto il nome, l’impiego e la zona in cui abitava, ma non l’indirizzo. Ogni partecipante doveva quindi inoltrare il pacchetto a chi, fra i suoi conoscenti, avesse a suo giudizio una maggiore probabilità di conoscere il destinatario. La persona scelta avrebbe poi fatto lo stesso, finché il pacchetto non fosse giunto nelle mani del destinatario. Tenendo traccia degli invii, Milgram determinò che il numero medio di intermediari necessari a connettere due persone fosse pari a 5,2, dando così origine al concetto dei sei gradi di separazione. Lo stesso numero, su Facebook, si è oggi ridotto a 3,57 (Bhagat et al., 2016). In altre parole, ogni persona è connessa ad ogni altra persona sulla piattaforma da una media di tre persone e mezza. È questo un esempio di come l’avvento delle nuove tecnologie, e in particolare dei social network, abbia rivoluzionato la maniera in cui comunichiamo e ci informiamo, modificando lo spazio informativo e consentendo a chiunque di produrre contenuti e condividere la propria opinione. Facciamo sempre più affidamento ad Internet e ai social media nella nostra vita quotidiana, sia civica che lavorativa. Nel quarto trimestre del 2018, Facebook vantava 2,32 miliardi di utenti attivi mensilmente (più della metà della popolazione mondiale online), mentre l’uso di WhatsApp per le notizie è triplicato dal 2014 (Nic et al., 2018). Si calcola che, solo su Facebook, ogni minuto vengano prodotti 2,46 milioni di post e cliccati 1,8 milioni di “mi piace”. I social media si sono rapidamente affermati come la principale fonte di informazione per molti dei loro utenti, che preferiscono accedere ai contenuti informativi attraverso i social, i motori di ricerca o gli aggregatori di notizie, piuttosto che navigando direttamente sul sito web della fonte. Ai mass media tradizionali come la stampa, la radio e la tv, si è affiancata negli anni una massa eterogenea di fonti di informazione, i cui contenuti non sono più mediati prima di giungere al grande pubblico. Si parla, infatti, di disintermediazione o, più recentemente, di neointermediazione (Giacomini, 2018), poiché a filtrare le notizie diventano spesso gli algoritmi, necessari per selezionare una quantità di informazioni altrimenti troppo ampia da poter essere afferrata.

Nonostante la notevole quantità di informazione, però, la qualità può essere scarsa, per motivi che spaziano dalla difficoltà di monetizzazione dei contenuti, alla continua riduzione degli investimenti in informazione, allo scarso uso di meccanismi di verifica nell’ambito della professione giornalistica (AGCOM, 2018). Si osserva, poi, un crescente accesso ai contenuti da smartphone e dispositivi mobili, incidendo sulle modalità e sui tempi in cui le informazioni vengono processate ed elaborate. Risulta evidente come tale contesto sia alla base della perdita di reputazione e fiducia da parte dei cittadini nei confronti del sistema informativo tradizionale, e possa spingere gli utenti ad affidarsi a fonti di informazione alternative, spesso non qualificate. È ormai dal 2013 che il World Economic Forum (WEF) annovera il rischio globale della disinformazione digitale di massa tra i maggiori rischi tecnologici e geopolitici della nostra era, al pari del crescente fanatismo religioso, gli attacchi cibernetici e il terrorismo (Howell, 2013). In ogni sua declinazione, dall’informazione deliberatamente falsa creata a danno d’altri, a quella inaccurata, ingannevole o fuorviante, fino alla mera propaganda, la disinformazione può avere effetti negativi sull’opinione pubblica e ripercussioni sulla società. A tal proposito, si pensi a Jade Helm 15, un’esercitazione militare svoltasi negli Stati Uniti nell’estate del 2015, che fu percepita da alcuni gruppi complottisti online come un tentativo di Barack Obama di imporre la legge marziale, al punto che il governatore del Texas Greg Abbott ordinò alla Guardia Nazionale di monitorare le operazioni. Similmente, dopo la morte di due persone per aver ingerito troppa acqua salata durante la più recente epidemia di Ebola in Africa, l’Organizzazione Mondiale della Sanità dovette ribadire che tutti i rumor circolanti online su fantomatiche cure o pratiche alternative non erano attendibili e che il loro utilizzo poteva rivelarsi molto pericoloso. O ancora, le già inadeguate politiche sanitarie in Sudafrica hanno causato la morte (evitabile) di più 300,000 persone per AIDS; ma questi tragici eventi sono stati esacerbati dai negazionisti, che sostengono che l’HIV sia inoffensivo e che i farmaci antiretrovirali causino l’infezione, invece di trattarla.

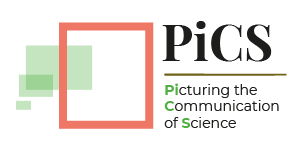

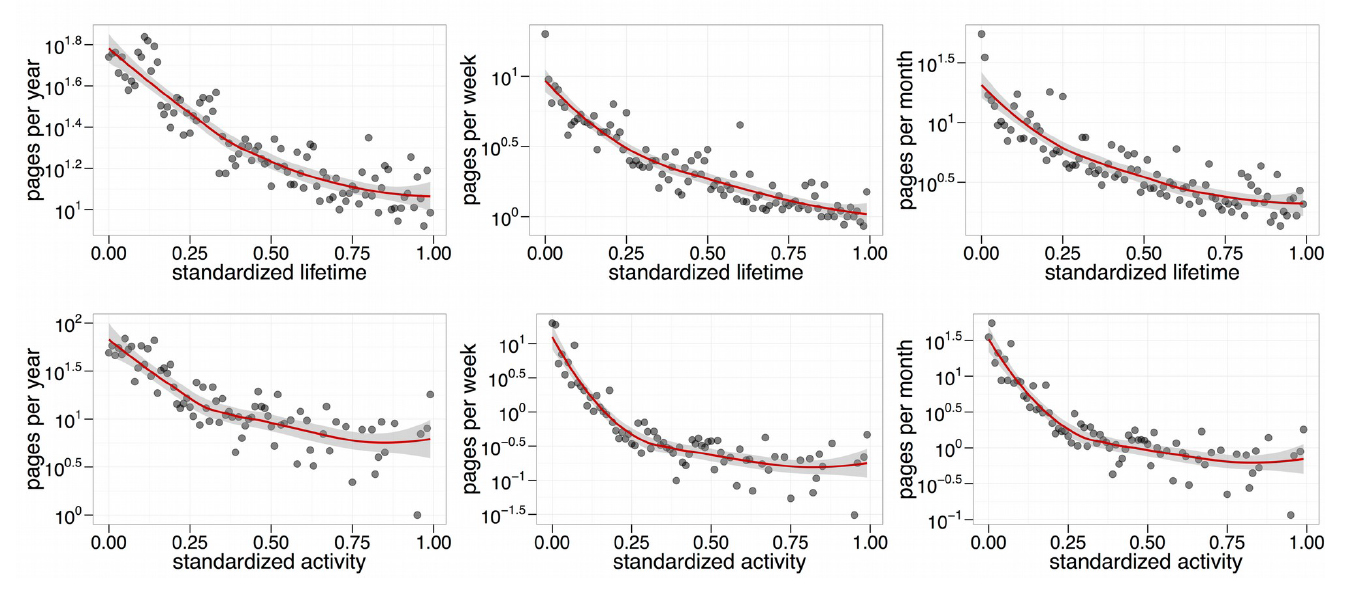

Su Internet, un’enorme quantità di informazioni compete per la nostra attenzione, che è tuttavia limitata. Mettere in atto le proprie capacità di analisi, riflessione e sintesi risulta spesso difficile; emergono, invece, i bias (o pregiudizi) cognitivi, ovvero scorciatoie, euristiche di cui ci serviamo per semplificare la realtà e (re)agire rapidamente. Mentre questi meccanismi si rivelano spesso fondamentali per la nostra stessa sopravvivenza, a volte possono trasformarsi in trappole mentali ed indurci in errore. I bias a cui siamo soggetti sono numerosi: si va dal bias di negatività, che ci fa sopravvalutare il pericolo, al bias di frequenza, che ci fa amplificare la probabilità degli eventi a cui prestiamo attenzione, al bias di omissione, che evita di farci agire pur di non sbagliare. Tra questi, un ruolo fondamentale nei processi di diffusione e selezione dell’informazione è svolto dal confirmation bias (pregiudizio di conferma), ovvero la tendenza umana a cercare informazioni che sono già coerenti con il proprio sistema di credenze. Nonostante la pressoché infinita varietà di informazione a disposizione, infatti, gli utenti online tendono a frammentarsi in bolle, ognuna caratterizzata da una propria narrativa e visione del mondo, le cosiddette echo chamber (Del Vicario, et al., 2016). All’interno di ciascuna comunità, gli utenti condividono interessi, selezionano informazioni, discutono e rinforzano le proprie credenze attorno ad una narrazione del mondo condivisa. La diffusione delle informazioni, infatti, è guidata dal già citato confirmation bias e dall’omofilia, la tendenza umana ad associarsi e creare legami con individui simili. . Gli utenti tendono a formare gruppi polarizzati i cui membri sono accumunati da una narrativa condivisa e, immersi nelle echo chamber, acquisiscono informazioni coerenti con la propria visione del mondo, anche se false (Zollo & Quattrociocchi, 2018a; Zollo & Quattrociocchi, 2018b). Utenti di echo chamber diverse (e contrastanti) raramente interagiscono e, quando questo accade, la discussione degenera, soprattutto se prolungata (Zollo et al., 2015). La reazione ai tentativi di correzione (debunking) di notizie interamente o parzialmente false non è poi così dissimile. Si osserva, infatti, il cosiddetto backfire effect, o effetto di rinforzo (Nyhan & Reifler, 2010). La correzione sembra essere percepita come un ulteriore tentativo di manipolazione dell’informazione, finendo col rafforzare le posizioni iniziali degli utenti (Zollo et al., 2017). Misurando l’eterogeneità dell’attività dell’utente è anche possibile quantificare il ricambio delle fonti di informazione. Ciò che si osserva è che, per livelli crescenti di attività (numero totale di like) e lifetime (distanza temporale tra la prima e l’ultima azione dell’utente sulla piattaforma), gli utenti interagiscono con un numero sempre inferiore di fonti (Schmidt et al, 2017). In particolare, mentre gli utenti caratterizzati da bassi livelli di attività e lifetime interagiscono con circa 100 pagine in un anno, 30 in un mese, e 10 in una settimana, gli stessi valori sono molto più bassi per gli utenti più attivi e longevi, che invece interagiscono con circa 10 pagine in un anno, e meno di 4 mensilmente e settimanalmente (Figura 1). La fruizione dei contenuti su Facebook, quindi, risulta dominata dall’esposizione selettiva, rivelando la tendenza naturale degli utenti a confinare la propria attività su un insieme limitato di pagine, concentrando la propria attenzione su certi argomenti (e argomentazioni) a scapito di altri, così contribuendo alla formazione di una struttura comunitaria fortemente polarizzata, caratterizzata da gruppi nettamente separati (Figura 2).

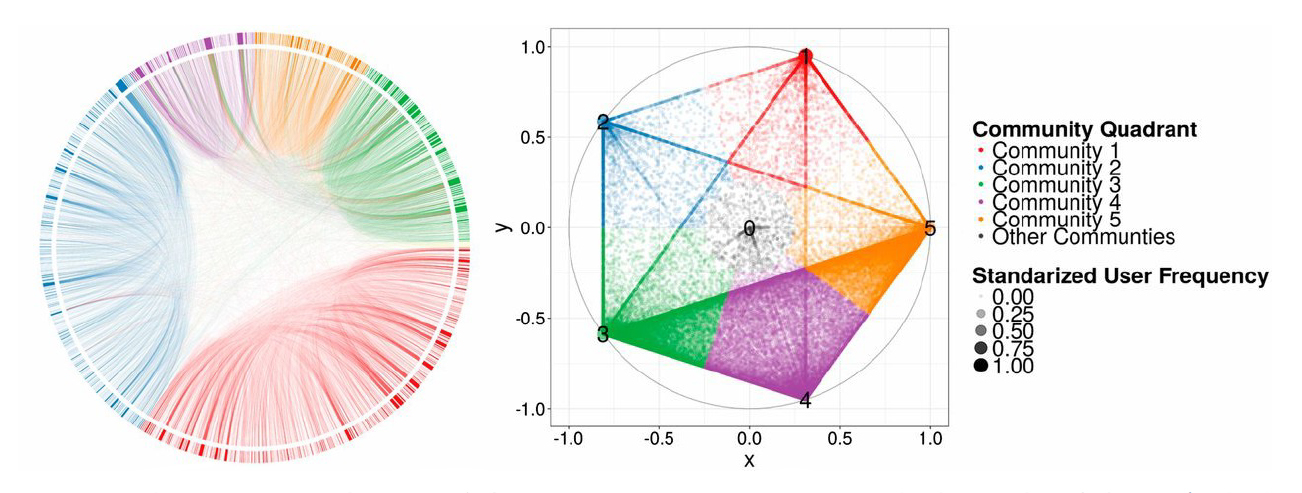

Le evidenze empiriche suggeriscono, quindi, che la diffusione della disinformazione sembra essere collegata alla crescente segregazione degli utenti in echo chamber. Per contrastare la disinformazione, e in generale favorire una comunicazione più efficace, attenuare la polarizzazione è dunque cruciale. A questo scopo, il comportamento degli utenti e le loro interazioni con i contenuti possono essere utilizzati per determinare in anticipo gli argomenti potenzialmente oggetto di disinformazione nel breve periodo (Del Vicario et al., 2019). Tra la pubblicazione di una notizia su Facebook e la comparsa delle prime controparti “false” trascorrono in media meno di 24 ore (Figura 3). Il tempo per agire, quindi, è limitato, ma un’identificazione tempestiva di questi target potrebbe consentire di sviluppare appropriate strategie di comunicazione e contro-narrative, e domare gli incendi informativi in tempo utile. Conoscendo i potenziali obiettivi, giornalisti e comunicatori potrebbero giocare d’anticipo ed informare in maniera più efficace, evitando di alimentare la polarizzazione degli utenti. In questa direzione, nell’ambito del progetto europeo QUEST3 stiamo lavorando proprio per definire, testare e valutare, in maniera quantitativa e insieme ai diversi attori coinvolti, differenti strategie per migliorare la comunicazione della scienza sui social media, prestando particolare attenzione a temi sensibili e fortemente polarizzanti, come il cambiamento climatico o i vaccini (Schmidt et al., 2018).

Risulta inoltre importante promuovere una cultura di apertura, che sottolinei l’importanza del confronto e dell’esercizio dello spirito critico, unitamente ad una maggiore conoscenza sia degli strumenti digitali che dei propri limiti (e bias) umani. A tale riguardo, è interessante ricordare come la consapevolezza che certi bias esistano e che possano avere un impatto sul nostro giudizio, non assicura comunque di esserne immuni, o di riuscire a riconoscerli (Pronin, Lin, & Ross, 2002). Il riconoscimento dei bias negli “altri”, unitamente al diniego rispetto a sé stessi, sono spesso inevitabili, e possono dare origine a fraintendimenti e conflitti che impediscono di trovare un punto di incontro. Ciò nonostante, resta di fondamentale importanza la consapevolezza che certi meccanismi siano propri a tutti gli esseri umani, e non siano ascrivibili solo a certi gruppi o categorie di individui (solitamente, “gli altri”).

Category:

Fabiana ZolloDate:

4 Dicembre 2020